Nagy nyelvi modellek (LLM): Teljes útmutató 2023-ban

Minden, amit az LLM-ről tudni kell

Index táblázat

- Bevezetés

- Mik azok a nagy nyelvi modellek?

- Alapvető tényezők

- Népszerű példák az LLM-re

- Az LLM-ek építőkövei

- Hogyan képezik az LLM modelleket?

- Az LLM a felügyelt vagy nem felügyelt tanulásra támaszkodik

- Vonat LLM

- Az LLM felemelkedése

- Az LLM népszerű használati esetei

- Biztonság és megfelelés

- LLM finomhangolása

- FAQ

Töltse le az e-könyvet

Bevezetés

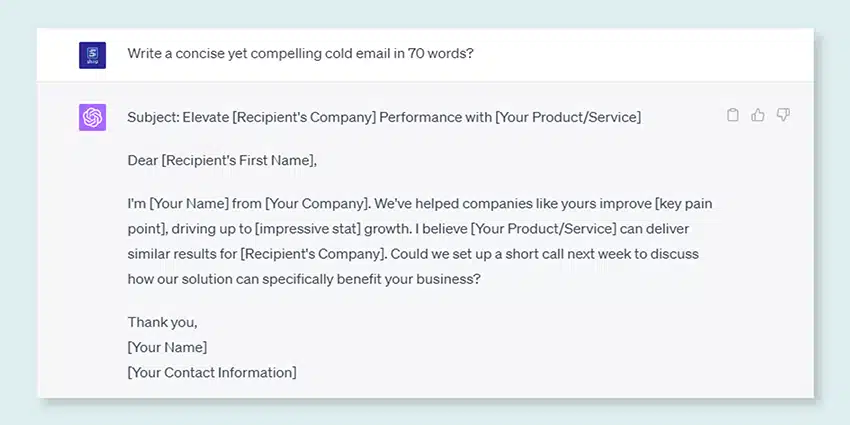

Vakarta valaha a fejét, és csodálkozott azon, hogy a Google vagy az Alexa mennyire „megkap”? Vagy azon kapta magát, hogy egy számítógéppel generált esszét olvas, amely kísértetiesen emberinek hangzik? Nem vagy egyedül. Ideje lerántani a rolót, és felfedni a titkot: a Large Language Models vagy az LLM-eket.

Mik ezek, kérdezed? Gondoljon az LLM-ekre, mint rejtett varázslókra. Működtetik digitális csevegéseinket, megértik zavaros kifejezéseinket, és még úgy is írnak, mint mi. Átalakítják az életünket, valósággá teszik a sci-fit.

Ez az útmutató minden LLM-ről szól. Megvizsgáljuk, mire képesek, mit nem, és hol használják őket. Megvizsgáljuk, milyen hatással vannak ránk, közérthető és egyszerű nyelvezeten.

Tehát kezdjük izgalmas utazásunkat az LLM-ek felé.

Kinek szól ez az útmutató?

Ez a részletes útmutató a következőkhöz szól:

- Önök, vállalkozók és soloprénuristák, akik rendszeresen gyűjtenek hatalmas mennyiségű adatot

- AI és gépi tanulás, vagy szakemberek, akik kezdik a folyamatoptimalizálási technikákat

- Azok a projektmenedzserek, akik gyorsabb időt kívánnak bevezetni a mesterséges intelligencia moduljaik vagy mesterséges intelligencia által vezérelt termékeik piacra dobására

- És azok a műszaki rajongók, akik szeretnek belemenni az AI-folyamatokban részt vevő rétegek részleteibe.

Mik azok a nagy nyelvi modellek?

A nagy nyelvi modellek (LLM-ek) fejlett mesterséges intelligencia-rendszerek, amelyeket emberi szöveg feldolgozására, megértésére és előállítására terveztek. Mélytanulási technikákon alapulnak, és hatalmas adatkészleteken dolgoznak, amelyek általában több milliárd szót tartalmaznak különféle forrásokból, például webhelyekről, könyvekről és cikkekről. Ez a kiterjedt képzés lehetővé teszi az LLM-ek számára, hogy megértsék a nyelv, a nyelvtan, a szövegkörnyezet árnyalatait és még az általános ismeretek egyes aspektusait is.

Egyes népszerű LLM-ek, mint például az OpenAI GPT-3, egyfajta neurális hálózatot alkalmaznak, amelyet transzformátornak neveznek, amely lehetővé teszi számukra, hogy figyelemre méltó szakértelemmel kezeljék az összetett nyelvi feladatokat. Ezek a modellek a feladatok széles skáláját képesek ellátni, például:

- Kérdések megválaszolása

- Összefoglaló szöveg

- Nyelvek fordítása

- Tartalom generálása

- Még a felhasználókkal folytatott interaktív beszélgetések is

Ahogy az LLM-k folyamatosan fejlődnek, nagy lehetőségek rejlenek bennük a különféle alkalmazások fejlesztésére és automatizálására az iparágakban, az ügyfélszolgálattól és a tartalomkészítéstől az oktatásig és a kutatásig. Ugyanakkor etikai és társadalmi aggályokat is felvetnek, mint például az elfogult viselkedés vagy a visszaélés, amelyeket a technológia fejlődésével kezelni kell.

LLM adatkorpusz létrehozásának alapvető tényezői

A nyelvi modellek sikeres betanításához átfogó adatkorpuszt kell felépítenie. Ez a folyamat magában foglalja a hatalmas adatgyűjtést, valamint azok magas minőségének és relevanciájának biztosítását. Nézzük meg azokat a kulcsfontosságú szempontokat, amelyek jelentősen befolyásolják a nyelvi modellképzés hatékony adattárának kialakítását.

A mennyiség mellett az adatminőséget részesítse előnyben

A nyelvi modellek betanításához elengedhetetlen egy nagy adatkészlet. Az adatok minőségének azonban nagy jelentősége van. A kiterjedt, de rosszul strukturált adatokra kiképzett modellek pontatlan eredményeket adhatnak.

Ezzel szemben a kisebb, aprólékosan összeállított adatkészletek gyakran kiváló teljesítményt eredményeznek. Ez a valóság mutatja az adatgyűjtés kiegyensúlyozott megközelítésének fontosságát. A reprezentatív, sokrétű és a modell tervezett hatókörének megfelelő adatok gondos kiválasztást, tisztítást és rendszerezést igényelnek.

Válassza ki a megfelelő adatforrásokat

Az adatforrások kiválasztásának összhangban kell lennie a modell konkrét alkalmazási céljaival.

- A párbeszédet generáló modellek hasznosak lehetnek az olyan forrásokból, mint a beszélgetések és az interjúk, felbecsülhetetlen értékűek.

- A kódgenerálásra összpontosító modellek számára előnyösek a jól dokumentált kódtárak.

- Az irodalmi művek és forgatókönyvek rengeteg képzési anyagot kínálnak a kreatív írást megcélzók számára.

Olyan adatokat kell tartalmaznia, amelyek a kívánt nyelvekre és témákra kiterjednek. Segít a modell testreszabásában, hogy hatékonyan működjön a kijelölt tartományon belül.

Szintetikus adatgenerálás használata

Az adatkészlet szintetikus adatokkal való bővítése kitöltheti a hiányosságokat, és kiterjesztheti a tartományt. Használhat adatkiegészítést, szöveggenerálási modelleket és szabályalapú generálást a valós mintákat tükröző mesterséges adatok létrehozásához. Ez a stratégia kibővíti a képzési készlet sokszínűségét, hogy növelje a modell ellenálló képességét és csökkentse a torzításokat.

Ügyeljen arra, hogy ellenőrizze a szintetikus adatok minőségét, hogy azok pozitívan járuljanak hozzá a modell azon képességéhez, hogy megértse és generálja a nyelvet a céltartományon belül.

Automatizált adatgyűjtés megvalósítása

Az adatgyűjtési folyamat automatizálása elősegíti a friss, releváns adatok következetes integrálását. Ez a megközelítés egyszerűsíti az adatgyűjtést, növeli a méretezhetőséget és elősegíti a reprodukálhatóságot.

Hatékonyan gyűjthet különféle adatkészleteket webes lemásoló eszközök, API-k és adatfeldolgozási keretrendszerek használatával. Finomhangolhatja ezeket az eszközöket, hogy a kiváló minőségű, releváns adatokra összpontosítson. Optimalizálják a modell tananyagát. Folyamatosan felügyelnie kell ezeket az automatizált rendszereket pontosságuk és etikai integritásuk megőrzése érdekében.

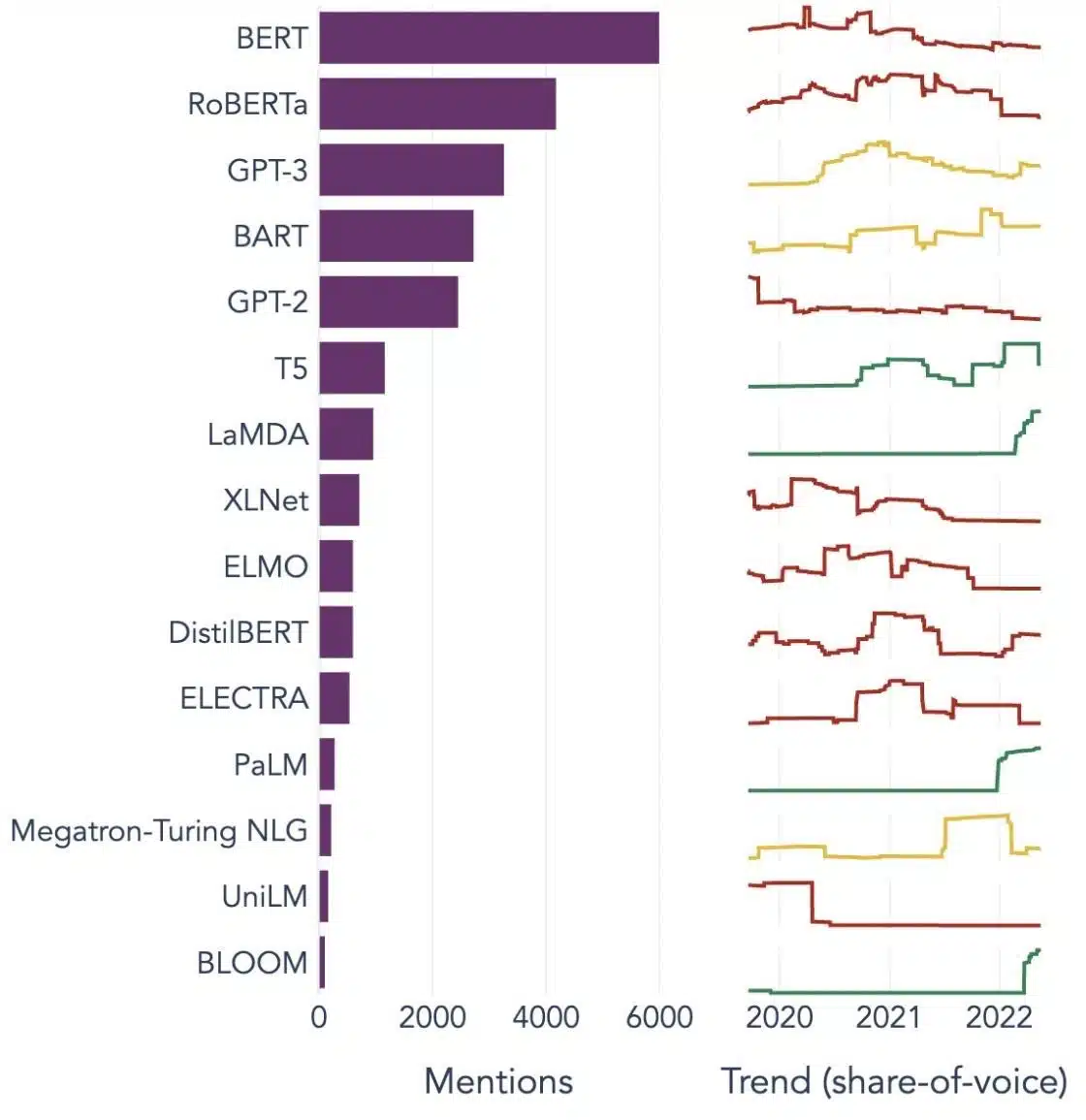

Népszerű példák nagy nyelvi modellekre

Íme néhány kiemelkedő példa a különböző iparági vertikumokban széles körben használt LLM-ekre:

Image Source: Adattudomány felé

A nagy nyelvi modellek (LLM) építőkövei

Az LLM-ek képességeinek és működésének teljes megértéséhez fontos, hogy megismerkedjünk néhány kulcsfogalommal. Ezek tartalmazzák:

Szó beágyazása

Ez a szavak olyan numerikus formátumba fordításának gyakorlatára vonatkozik, amelyet az AI-modellek képesek értelmezni. Lényegében a szóbeágyazás az AI nyelve. Minden szó egy nagy dimenziós vektorként jelenik meg, amely a szemantikai jelentését a kontextusa alapján tartalmazza a betanítási adatokban. Ezek a vektorok lehetővé teszik a mesterséges intelligencia számára, hogy megértse a szavak közötti kapcsolatokat és hasonlóságokat, javítva a modell megértését és teljesítményét.

Figyelemmechanizmusok

Ezek a kifinomult komponensek segítenek az AI-modellnek abban, hogy a bemeneti szöveg egyes elemei prioritást adjanak a többihez képest, amikor kimenetet generál. Például egy különböző érzésekkel teli mondatban egy figyelemmechanizmus nagyobb súlyt adhat az érzelmeket hordozó szavaknak. Ez a stratégia lehetővé teszi az AI számára, hogy kontextuálisan pontosabb és árnyaltabb válaszokat generáljon.

transzformerek

A transzformátorok a neurális hálózati architektúra fejlett típusát képviselik, amelyet széles körben alkalmaznak az LLM-kutatásban. A transzformátorokat az önfigyelő mechanizmus különbözteti meg egymástól. Ez a mechanizmus lehetővé teszi a modell számára, hogy a bemeneti adatok minden részét egyidejűleg mérlegelje és vegye figyelembe, nem pedig egymás utáni sorrendben. Az eredmény a szöveg hosszú távú függőségei kezelésének javulása, ami gyakori kihívás a természetes nyelvi feldolgozási feladatokban.

Finomhangolás

Még a legfejlettebb LLM-eknek is szükségük van némi testreszabásra, hogy kitűnjenek bizonyos feladatokban vagy tartományokban. Itt jön a képbe a finomhangolás. Miután egy modellt kezdetben betanítottak egy nagy adatkészletre, tovább finomítható vagy „finomhangolható” egy kisebb, specifikusabb adatkészleten. Ez a folyamat lehetővé teszi a modell számára, hogy általánosított nyelvértési képességeit egy speciálisabb feladathoz vagy kontextushoz igazítsa.

Prompt Engineering

A bemeneti promptok kiindulási pontként szolgálnak az LLM-eknek a kimenetek generálásához. Ezeknek a felszólításoknak a hatékony kidolgozása – ez a gyakorlat az azonnali tervezésként ismert – nagymértékben befolyásolhatja a modell válaszainak minőségét. Ez a művészet és a tudomány keveréke, amely megköveteli annak alapos megértését, hogy a modell hogyan értelmezi a felszólításokat és hogyan generál válaszokat.

Előítélet

Ahogy az LLM-ek tanulnak az általuk kiképzett adatokból, az ezekben az adatokban jelenlévő torzítások beszivároghatnak a modell viselkedésébe. Ez diszkriminatív vagy tisztességtelen tendenciákként nyilvánulhat meg a modell eredményeiben. Ezen elfogultságok kezelése és mérséklése jelentős kihívást jelent a mesterséges intelligencia területén, és döntő szempont az etikailag megalapozott LLM-ek fejlesztésében.

Értelmezhetőség

Tekintettel az LLM-ek összetettségére, kihívást jelenthet megérteni, hogy miért hoznak bizonyos döntéseket vagy hoznak létre konkrét kimeneteket. Ez az értelmezhetőségnek nevezett jellemző a folyamatban lévő kutatások kulcsterülete. Az értelmezhetőség javítása nemcsak a hibaelhárításban és a modellfinomításban segít, hanem megerősíti az AI-rendszerekbe vetett bizalmat és az átláthatóságot is.

Hogyan képezik az LLM modelleket?

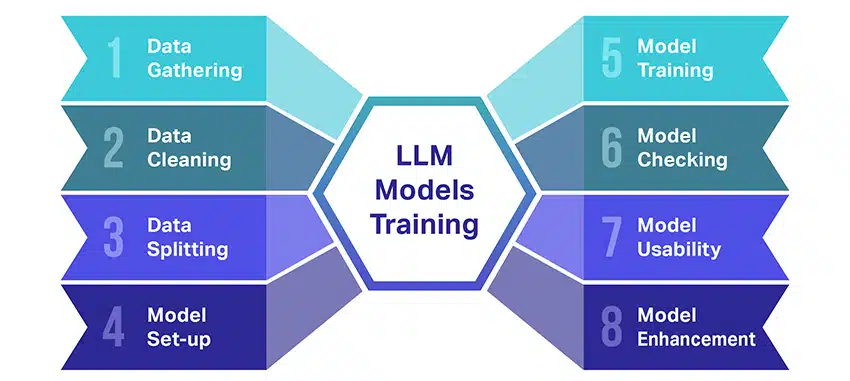

A nagy nyelvi modellek (LLM) betanítása meglehetősen nagy teljesítmény, amely több döntő lépést foglal magában. Íme a folyamat leegyszerűsített, lépésről lépésre történő leírása:

- Szöveges adatok gyűjtése: Az LLM képzése hatalmas mennyiségű szöveges adat összegyűjtésével kezdődik. Ezek az adatok származhatnak könyvekből, webhelyekről, cikkekből vagy közösségi média platformokról. A cél az emberi nyelv gazdag sokszínűségének megragadása.

- Az adatok tisztítása: A nyers szöveges adatokat ezután egy előfeldolgozásnak nevezett folyamatban rendezik. Ez magában foglal olyan feladatokat, mint a nem kívánt karakterek eltávolítása, a szöveg kisebb részekre, úgynevezett tokenekre bontása, és az egésznek olyan formátumba állítása, amellyel a modell képes működni.

- Az adatok felosztása: Ezután a tiszta adatokat két csoportra osztják. Az egyik halmazt, a betanítási adatokat használjuk fel a modell betanításához. A másik halmazt, az érvényesítési adatokat később a modell teljesítményének tesztelésére használjuk fel.

- A modell beállítása: Ezután meghatározzák az LLM szerkezetét, amelyet architektúrának neveznek. Ez magában foglalja a neurális hálózat típusának kiválasztását és a különféle paraméterek, például a hálózaton belüli rétegek és rejtett egységek számának meghatározását.

- A modell betanítása: A tényleges képzés most kezdődik. Az LLM-modell úgy tanul, hogy megnézi a betanítási adatokat, előrejelzéseket készít az eddig tanultak alapján, majd belső paramétereit úgy állítja be, hogy csökkentse az előrejelzései és a tényleges adatok közötti különbséget.

- A modell ellenőrzése: Az LLM modell tanulását a validációs adatok segítségével ellenőrzik. Ez segít megnézni, hogy a modell milyen jól teljesít, és a jobb teljesítmény érdekében módosítani tudja a modell beállításait.

- A modell használata: Betanítás és értékelés után az LLM modell használatra kész. Most már integrálható alkalmazásokba vagy rendszerekbe, ahol szöveget generál a kapott új bemenetek alapján.

- A modell fejlesztése: Végül mindig van hova fejlődni. Az LLM-modell idővel tovább finomítható frissített adatok felhasználásával vagy a beállítások visszajelzések és valós használat alapján történő módosításával.

Ne feledje, ez a folyamat jelentős számítási erőforrásokat igényel, például nagy teljesítményű feldolgozóegységeket és nagy tárhelyet, valamint speciális gépi tanulási ismereteket. Ez az oka annak, hogy ezt általában elkötelezett kutatószervezetek vagy cégek végzik, amelyek hozzáféréssel rendelkeznek a szükséges infrastruktúrához és szakértelemhez.

Az LLM felügyelt vagy nem felügyelt tanulásra támaszkodik?

A nagy nyelvi modelleket általában a felügyelt tanulásnak nevezett módszerrel képezik. Leegyszerűsítve ez azt jelenti, hogy olyan példákból tanulnak, amelyek megmutatják nekik a helyes válaszokat.

Tehát, ha egy LLM-nek betáplál egy mondatot, az megpróbálja megjósolni a következő szót vagy kifejezést a példákból tanultak alapján. Így megtanulja, hogyan lehet értelmes és a kontextushoz illeszkedő szöveget generálni.

Ennek ellenére néha az LLM-ek egy kis felügyelet nélküli tanulást is alkalmaznak. Ez olyan, mintha hagyná, hogy a gyermek felfedezze a különféle játékokkal teli szobát, és önállóan tanuljon róluk. A modell címkézetlen adatokat, tanulási mintákat és struktúrákat vizsgál anélkül, hogy megmondaná a „helyes” válaszokat.

A felügyelt tanulás bemenetekkel és kimenetekkel címkézett adatokat használ, ellentétben a felügyelt tanulással, amely nem használ felcímkézett kimeneti adatokat.

Dióhéjban az LLM-eket főként felügyelt tanulással képezik, de használhatják a felügyelet nélküli tanulást is képességeik fejlesztésére, például feltáró elemzésre és dimenziócsökkentésre.

Mekkora adatmennyiség (GB-ban) szükséges egy nagy nyelvi modell betanításához?

A beszédadat-felismerés és a hangalkalmazások lehetőségeinek világa óriási, és ezeket számos iparágban használják számos alkalmazáshoz.

Egy nagy nyelvi modell betanítása nem egy mindenki számára megfelelő folyamat, különösen, ha a szükséges adatokról van szó. Ez egy csomó dologtól függ:

- A modell kialakítása.

- Milyen munkát kell végeznie?

- A használt adatok típusa.

- Mennyire szeretnéd, hogy jól teljesítsen?

Ennek ellenére az LLM-ek képzése általában hatalmas mennyiségű szöveges adatot igényel. De milyen tömegről beszélünk? Nos, gondoljon a gigabájtokon (GB) túl. Általában terabájt (TB) vagy akár petabájt (PB) adatot vizsgálunk.

Tekintsük a GPT-3-at, az egyik legnagyobb LLM-et. Ki van képezve 570 GB szöveges adat. A kisebb LLM-eknek talán kevesebbre van szükségük – talán 10-20 GB-ra vagy akár 1 GB gigabájtra is –, de ez még mindig sok.

De ez nem csak az adatok nagyságán múlik. A minőség is számít. Az adatoknak tisztának és változatosnak kell lenniük ahhoz, hogy a modell hatékonyan tanulhasson. És nem feledkezhet meg a rejtvény egyéb kulcsfontosságú elemeiről sem, például a szükséges számítási teljesítményről, az edzéshez használt algoritmusokról és a hardverbeállításról. Mindezek a tényezők nagy szerepet játszanak az LLM képzésében.

A nagy nyelvi modellek felemelkedése: Miért fontosak?

Az LLM-ek már nem csak egy koncepció vagy egy kísérlet. Egyre fontosabb szerepet játszanak digitális környezetünkben. De miért történik ez? Mitől olyan fontosak ezek az LLM-ek? Nézzünk meg néhány kulcsfontosságú tényezőt.

Mesterséges emberi szöveg utánzás

Az LLM-ek megváltoztatták a nyelvi alapú feladatok kezelésének módját. A robusztus gépi tanulási algoritmusok felhasználásával készült modellek képesek megérteni az emberi nyelv árnyalatait, beleértve a kontextust, az érzelmeket és bizonyos mértékig a szarkazmust is. Ez az emberi nyelv utánzási képesség nem pusztán újdonság, hanem jelentős következményekkel jár.

Az LLM-ek fejlett szöveggeneráló képességei mindent javíthatnak a tartalomkészítéstől az ügyfélszolgálati interakcióig.

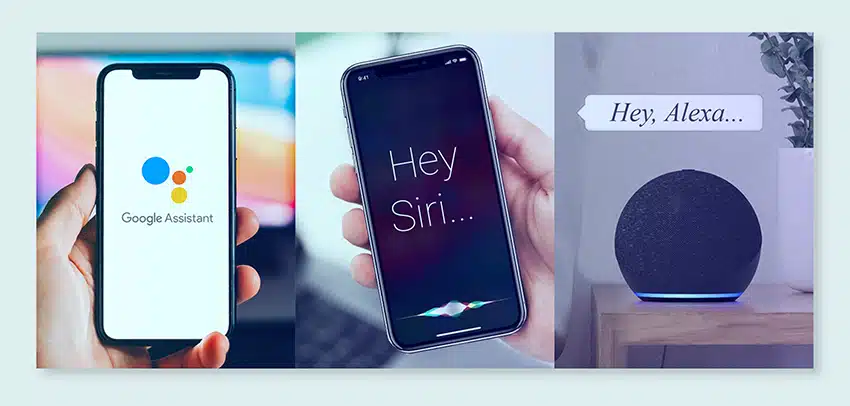

Képzelje el, hogy feltehet egy digitális asszisztensnek egy összetett kérdést, és olyan választ kap, amely nemcsak értelmes, hanem koherens, releváns és társalgási hangnemben is megvan. Az LLM-ek ezt teszik lehetővé. Intuitívabb és vonzóbb ember-gép interakciót segítenek elő, gazdagítják a felhasználói élményt, és demokratizálják az információkhoz való hozzáférést.

Megfizethető számítási teljesítmény

Az LLM-ek felemelkedése nem jöhetett volna létre párhuzamos fejlesztések nélkül a számítástechnika területén. Pontosabban, a számítási erőforrások demokratizálódása jelentős szerepet játszott az LLM-ek fejlődésében és elfogadásában.

A felhőalapú platformok példátlan hozzáférést kínálnak a nagy teljesítményű számítási erőforrásokhoz. Így még kisméretű szervezetek és független kutatók is kifinomult gépi tanulási modelleket képezhetnek.

Sőt, a feldolgozó egységek (például a GPU-k és TPU-k) fejlesztései az elosztott számítástechnika térnyerésével kombinálva lehetővé tették a több milliárd paraméterrel rendelkező modellek betanítását. A számítási teljesítmény megnövekedett hozzáférhetősége lehetővé teszi az LLM-ek növekedését és sikerét, ami több innovációt és alkalmazást eredményez ezen a területen.

Fogyasztói preferenciák megváltoztatása

A fogyasztók ma nem csak válaszokat akarnak; vonzó és rokonítható interakciókra vágynak. Ahogy egyre többen nőnek fel a digitális technológia használatával, nyilvánvaló, hogy egyre növekszik az igény a természetesebbnek és emberibbnek tűnő technológia iránt. Az LLM-ek páratlan lehetőséget kínálnak ezeknek az elvárásoknak a teljesítésére. Az emberszerű szöveg generálásával ezek a modellek vonzó és dinamikus digitális élményeket hozhatnak létre, amelyek növelhetik a felhasználók elégedettségét és lojalitását. Legyen szó ügyfélszolgálatot nyújtó mesterséges intelligencia chatbotokról vagy hírfrissítésekről hangos asszisztensekről, az LLM-ek a mesterséges intelligencia egy olyan korszakát nyitják meg, amely jobban megért minket.

A strukturálatlan adatok aranybánya

A strukturálatlan adatok, például az e-mailek, a közösségi médiában közzétett bejegyzések és a vásárlói vélemények a betekintések tárházát jelentik. Becslések szerint ennek vége 80% A vállalati adatok strukturálatlanok és ütemben növekszenek 55% évente. Ezek az adatok megfelelő tőkeáttétel esetén aranybánya a vállalkozások számára.

Az LLM-ek itt jönnek szóba, mivel képesek az ilyen adatokat nagy léptékben feldolgozni és értelmezni. Olyan feladatokat tudnak kezelni, mint a hangulatelemzés, a szövegosztályozás, az információ kinyerése és még sok más, ezáltal értékes betekintést nyújtanak.

Legyen szó trendek azonosításáról közösségi médiában közzétett bejegyzésekből, vagy az ügyfelek véleményének értékeléséből, az LLM-ek segítenek a vállalkozásoknak eligazodni a nagy mennyiségű strukturálatlan adat között, és adatvezérelt döntéseket hozni.

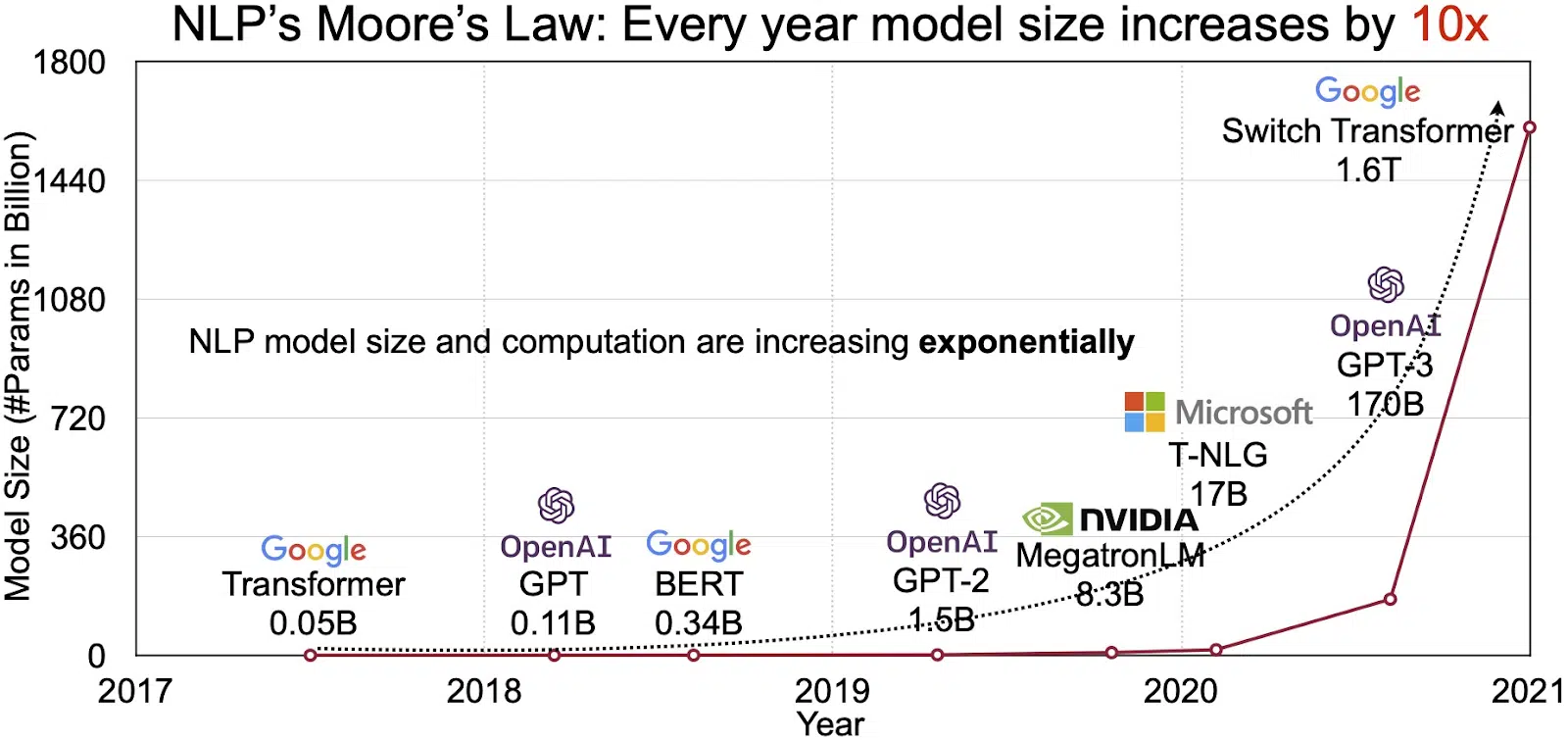

A bővülő NLP piac

Az LLM-ekben rejlő lehetőségek a természetes nyelvi feldolgozás (NLP) gyorsan növekvő piacán tükröződnek. Elemzők előrejelzése szerint az NLP piac bővülni fog 11 milliárd dollár 2020-ban, 35-ra több mint 2026 milliárd dollár. De nem csak a piac mérete bővül. Maguk a modellek is növekednek, mind fizikai méretükben, mind a kezelt paraméterek számában. Az LLM-ek fejlődése az évek során, amint az az alábbi ábrán látható (a kép forrása: link), rámutat növekvő összetettségükre és kapacitásukra.

A nagy nyelvű modellek népszerű használati esetei

Íme néhány az LLM legnépszerűbb és legelterjedtebb felhasználási esetei:

- Természetes nyelvű szöveg létrehozása: A nagy nyelvi modellek (LLM) a mesterséges intelligencia és a számítógépes nyelvészet erejét ötvözik, hogy autonóm módon állítsanak elő szövegeket természetes nyelven. Különféle felhasználói igényeket tudnak kielégíteni, például cikkeket írhatnak, dalokat készíthetnek vagy beszélgetéseket folytathatnak a felhasználókkal.

- Fordítás gépeken keresztül: Az LLM-ek hatékonyan használhatók bármilyen nyelvpár közötti szöveg fordítására. Ezek a modellek mély tanulási algoritmusokat, például visszatérő neurális hálózatokat használnak ki, hogy megértsék mind a forrás-, mind a célnyelvek nyelvi szerkezetét, ezáltal megkönnyítve a forrásszöveg lefordítását a kívánt nyelvre.

- Eredeti tartalom elkészítése: Az LLM-ek utakat nyitottak a gépek számára összefüggő és logikus tartalom létrehozására. Ez a tartalom blogbejegyzések, cikkek és más típusú tartalom létrehozására használható. A modellek mélyreható, mély tanulási tapasztalataikat kihasználva újszerű és felhasználóbarát módon formázzák és strukturálják a tartalmat.

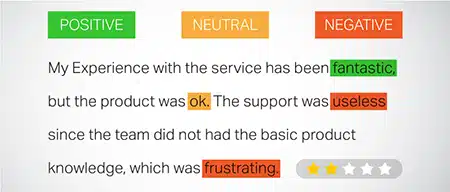

- Érzelmek elemzése: A Large Language Models egyik érdekes alkalmazása a hangulatelemzés. Ebben a modellt arra tanítják, hogy felismerje és kategorizálja az annotált szövegben jelenlévő érzelmi állapotokat és érzéseket. A szoftver képes azonosítani az érzelmeket, például a pozitivitást, a negativitást, a semlegességet és más bonyolult érzelmeket. Ez értékes betekintést nyújthat az ügyfelek visszajelzéseibe és a különféle termékekről és szolgáltatásokról alkotott véleményébe.

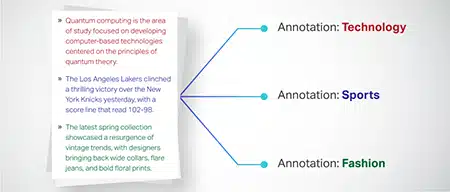

- Szöveg értelmezése, összefoglalása és osztályozása: Az LLM-ek életképes struktúrát hoznak létre az AI-szoftver számára a szöveg és a szövegkörnyezet értelmezéséhez. Azáltal, hogy a modellt hatalmas mennyiségű adat megértésére és vizsgálatára utasítják, az LLM-ek lehetővé teszik az AI-modellek számára, hogy megértsék, összegezzék, sőt kategorizálják a szöveget különböző formákban és mintákban.

- Kérdések megválaszolása: A nagy nyelvi modellek a Question Answering (QA) rendszereket olyan képességgel látják el, hogy pontosan érzékeljék és válaszoljanak a felhasználó természetes nyelvű lekérdezésére. Népszerű példák erre a használati esetre: a ChatGPT és a BERT, amelyek egy lekérdezés kontextusát vizsgálják, és szövegek hatalmas gyűjteményét kutatják át, hogy releváns válaszokat adjanak a felhasználói kérdésekre.

A biztonság és a megfelelőség integrálása az LLM adatstratégiákba

A robusztus biztonsági és megfelelőségi intézkedések beágyazása az LLM adatgyűjtési és -feldolgozási keretrendszerébe segíthet az adatok átlátható, biztonságos és etikus felhasználásának biztosításában. Ez a megközelítés több kulcsfontosságú tevékenységet foglal magában:

- Robusztus titkosítás megvalósítása: Az adatok védelme nyugalmi állapotban és továbbítás közben erős titkosítási módszerekkel. Ez a lépés megvédi az információkat a jogosulatlan hozzáféréstől és a jogsértésektől.

- Hozzon létre hozzáférés-vezérlést és hitelesítést: Rendszerek beállítása a felhasználói azonosságok ellenőrzésére és az adatokhoz való hozzáférés korlátozására. Ez biztosítja, hogy csak az arra feljogosított személyzet kommunikálhasson érzékeny információkkal.

- Integrálja a naplózási és megfigyelési rendszereket: Telepítsen rendszereket az adathasználat nyomon követésére és a lehetséges biztonsági fenyegetések azonosítására. Ez a proaktív megfigyelés segít megőrizni az adatökoszisztéma integritását és biztonságát.

- Tartsa be a megfelelőségi szabványokat: Kövesse a vonatkozó előírásokat, például a GDPR-t, a HIPAA-t és a PCI DSS-t, amelyek szabályozzák az adatbiztonságot és az adatvédelmet. A rendszeres auditok és ellenőrzések igazolják a megfelelőséget, biztosítva, hogy a gyakorlatok megfeleljenek az iparág-specifikus jogi és etikai normáknak.

- Állítsa be az etikai adathasználati irányelveket: Olyan irányelvek kidolgozása és érvényesítése, amelyek előírják az adatok tisztességes, átlátható és elszámoltatható felhasználását. Ezek az irányelvek segítenek fenntartani az érdekelt felek bizalmát, és támogatják az LLM-ek biztonságos képzési környezetét.

Ezek az intézkedések együttesen erősítik az LLM képzés adatkezelési gyakorlatát. A bizalom és biztonság alapjait építi ki, amely minden érintett fél számára előnyös.

Nagy nyelvű modell finomhangolása

Egy nagy nyelvi modell finomhangolása aprólékos annotációs folyamatot igényel. A Shaip ezen a területen szerzett szakértelmével jelentősen segítheti ezt a törekvést. Íme néhány annotációs módszer, amelyet a ChatGPT-hez hasonló modellek betanításához használnak:

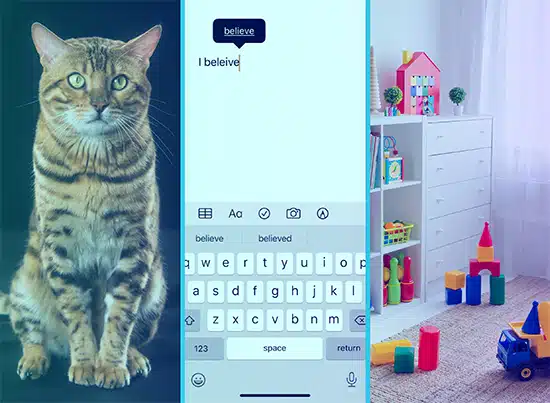

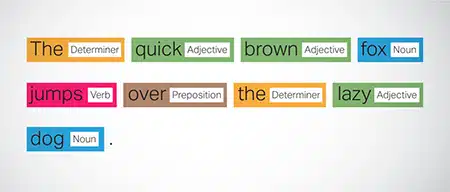

Beszédrészes (POS) címkézés

A mondatokban szereplő szavak nyelvtani funkciójukkal vannak megjelölve, például igék, főnevek, melléknevek stb. Ez a folyamat segíti a modellt a nyelvtan és a szavak közötti kapcsolatok megértésében.

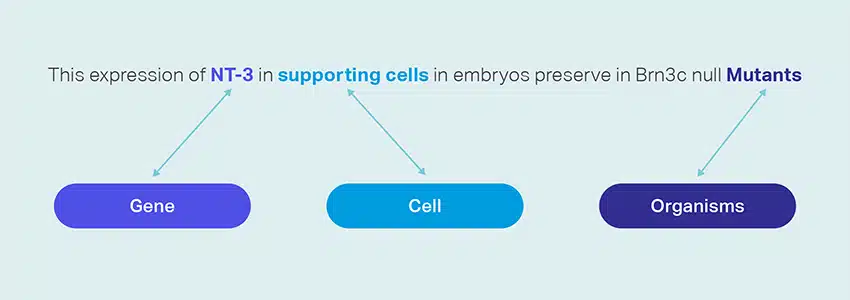

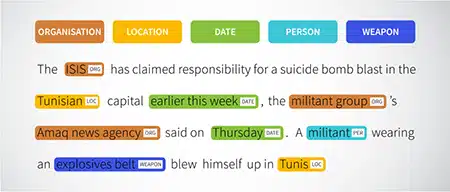

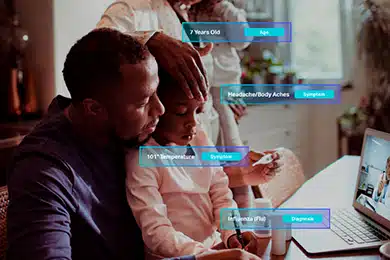

Elnevezett entitás-felismerés (NER)

A megnevezett entitások, például szervezetek, helyek és személyek egy mondaton belül meg vannak jelölve. Ez a gyakorlat segíti a modellt a szavak és kifejezések szemantikai jelentésének értelmezésében, és pontosabb válaszokat ad.

Érzelmi elemzés

A szöveges adatokhoz érzelmi címkéket rendelnek, például pozitív, semleges vagy negatív, így segít a modellnek megragadni a mondatok érzelmi felhangját. Különösen hasznos az érzelmekkel és véleményekkel kapcsolatos kérdések megválaszolásakor.

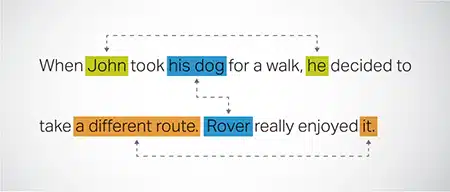

Coreference Resolution

Olyan esetek azonosítása és feloldása, amikor ugyanarra az entitásra hivatkoznak a szöveg különböző részei. Ez a lépés segít a modellnek megérteni a mondat kontextusát, így koherens válaszokhoz vezet.

Szöveg osztályozása

A szöveges adatok előre meghatározott csoportokba vannak sorolva, például termékismertetők vagy hírcikkek. Ez segíti a modellt a szöveg műfajának vagy témájának felismerésében, és relevánsabb válaszokat generál.

Shaip webes feltérképezéssel képzési adatokat gyűjthet különböző ágazatokból, például banki, biztosítási, kiskereskedelmi és telekommunikációs szektorból. Szöveges annotációt (NER, hangulatelemzés stb.) biztosítunk, megkönnyítjük a többnyelvű LLM-et (fordítás), valamint segítséget nyújtunk a taxonómia létrehozásában, kinyerésében/prompt tervezésében.

A Shaip széles tárházával rendelkezik a készen kapható adatkészletekből. Orvosi adatkatalógusunk azonosítatlan, biztonságos és minőségi adatok széles gyűjteményével büszkélkedhet, amelyek alkalmasak mesterséges intelligencia kezdeményezésekre, gépi tanulási modellekre és természetes nyelvi feldolgozásra.

Hasonlóképpen, beszédadat-katalógusunk a kiváló minőségű adatok tárháza, amely tökéletes a hangfelismerő termékekhez, lehetővé téve az AI/ML modellek hatékony betanítását. Lenyűgöző számítógépes látási adatkatalógusunk is van kép- és videoadatok széles skálájával a különböző alkalmazásokhoz.

Sőt nyílt adatkészleteket is kínálunk módosítható és kényelmes formában, ingyenesen az AI és ML projektjeihez. Ez a hatalmas mesterségesintelligencia-adattár lehetővé teszi az AI és ML modellek hatékonyabb és pontosabb fejlesztését.

Shaip adatgyűjtési és annotációs folyamata

Ha adatgyűjtésről és annotálásról van szó, Shaip áramvonalas munkafolyamatot követ. Így néz ki az adatgyűjtési folyamat:

Forráswebhelyek azonosítása

Kezdetben a webhelyeket kiválasztott források és a szükséges adatok szempontjából releváns kulcsszavak alapján határozzák meg.

Webes kaparás

A releváns webhelyek azonosítása után a Shaip saját fejlesztésű eszközét használja az adatok lekaparására ezekről a webhelyekről.

Szöveg előfeldolgozása

Az összegyűjtött adatok kezdeti feldolgozáson esnek át, amely magában foglalja a mondat felosztását és elemzését, így alkalmassá válik a további lépésekre.

Jegyzet

Az előfeldolgozott adatok a Megnevezett entitások kibontásához megjegyzésekkel vannak ellátva. Ez a folyamat magában foglalja a szövegben található fontos elemek azonosítását és címkézését, például személyek, szervezetek, helyek stb. nevét.

Kapcsolat kivonása

Az utolsó lépésben meghatározzák az azonosított entitások közötti kapcsolatok típusait, és ennek megfelelően jelölik őket. Ez segít megérteni a szemantikai kapcsolatokat a szöveg különböző összetevői között.

Shaip ajánlata

Shaip szolgáltatások széles skáláját kínálja, hogy segítse a szervezeteket adataik kezelésében, elemzésében és a legtöbbet kihozni belőlük.

Adatok webkaparása

A Shaip által kínált egyik legfontosabb szolgáltatás az adatlekopás. Ez magában foglalja az adatok kinyerését a domain-specifikus URL-ekből. Automatizált eszközök és technikák használatával a Shaip gyorsan és hatékonyan nagy mennyiségű adatot tud lekaparni különböző webhelyekről, termékkézikönyvekből, műszaki dokumentációkból, online fórumokról, online áttekintésekről, ügyfélszolgálati adatokról, ipari szabályozási dokumentumokról stb. Ez a folyamat felbecsülhetetlen értékű lehet a vállalkozások számára, amikor releváns és konkrét adatok gyűjtése számos forrásból.

Gépi fordítás

Modelleket dolgozzon ki kiterjedt többnyelvű adatkészletek és megfelelő átírások segítségével a szöveg különböző nyelvekre történő fordításához. Ez a folyamat segít a nyelvi akadályok lebontásában és elősegíti az információk hozzáférhetőségét.

Taxonómia kivonás és létrehozás

A Shaip segíthet a taxonómia kinyerésében és létrehozásában. Ez magában foglalja az adatok osztályozását és kategorizálását egy strukturált formátumba, amely tükrözi a különböző adatpontok közötti kapcsolatokat. Ez különösen hasznos lehet a vállalkozások számára adataik rendszerezése során, így könnyebben hozzáférhetővé és könnyebben elemezhetővé válik. Például egy e-kereskedelmi vállalkozásban a termékadatokat terméktípus, márka, ár stb. alapján lehet kategorizálni, így az ügyfelek könnyebben navigálhatnak a termékkatalógusban.

Adatgyűjtés

Adatgyűjtési szolgáltatásaink kritikus, valós vagy szintetikus adatokat biztosítanak, amelyek szükségesek a generatív AI-algoritmusok betanításához, valamint a modellek pontosságának és hatékonyságának javításához. Az adatok elfogulatlanok, etikusan és felelősségteljesen származnak, szem előtt tartva az adatok védelmét és biztonságát.

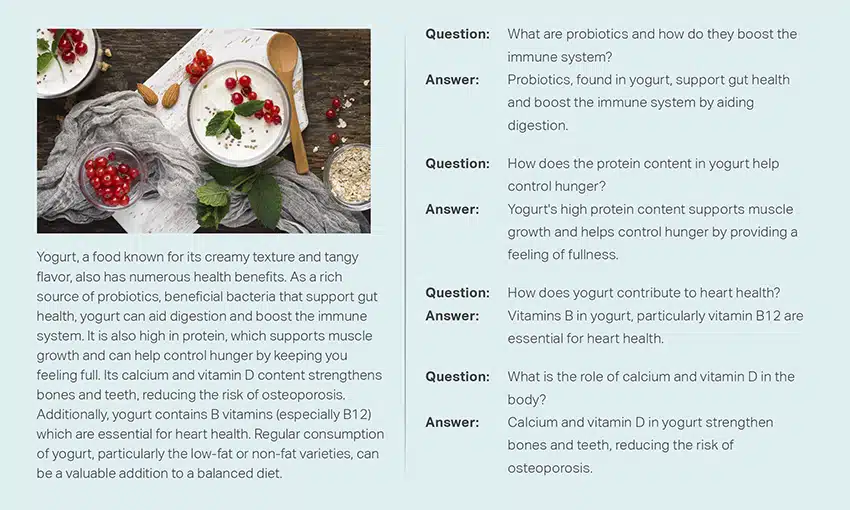

Kérdés és válasz

A kérdések megválaszolása (QA) a természetes nyelvi feldolgozás egy részterülete, amely a kérdések emberi nyelven történő automatikus megválaszolására összpontosít. A minőségbiztosítási rendszerek kiterjedt szövegekre és kódokra vannak kiképezve, lehetővé téve számukra, hogy különféle típusú kérdéseket kezeljenek, beleértve a tényszerű, definíciós és véleményalapú kérdéseket. A tartományi ismeretek kulcsfontosságúak a minőségbiztosítási modellek kidolgozásához, amelyek bizonyos területekre, például ügyfélszolgálatra, egészségügyre vagy ellátási láncra vannak szabva. A generatív minőségbiztosítási megközelítések azonban lehetővé teszik a modellek számára, hogy szöveget generáljanak tartományismeret nélkül, kizárólag a kontextusra támaszkodva.

Szakértői csapatunk aprólékosan tanulmányozhatja az átfogó dokumentumokat vagy kézikönyveket, hogy kérdés-válasz párokat hozzon létre, megkönnyítve ezzel a generatív mesterséges intelligencia létrehozását a vállalkozások számára. Ez a megközelítés hatékonyan képes kezelni a felhasználói kérdéseket azáltal, hogy egy kiterjedt korpuszból bányászza ki a vonatkozó információkat. Minősített szakértőink biztosítják a csúcsminőségű kérdés-felelet párok létrehozását, amelyek különböző témákat és területeket ölelnek fel.

Szöveg Összegzés

Szakembereink képesek átfogó beszélgetések vagy hosszadalmas párbeszédek desztillálására, tömör és szemléletes összefoglalók készítésére kiterjedt szöveges adatokból.

Szöveggenerálás

Tanítson modelleket különféle stílusú szövegek széles adatkészletével, például hírcikkek, szépirodalom és költészet segítségével. Ezek a modellek aztán különféle típusú tartalmakat generálhatnak, beleértve a híreket, blogbejegyzéseket vagy közösségi média bejegyzéseket, így költséghatékony és időtakarékos megoldást kínálnak a tartalomkészítéshez.

Speech Recognition

A beszélt nyelv megértésére képes modellek kidolgozása különféle alkalmazásokhoz. Ez magában foglalja a hanggal aktiválható asszisztenseket, a diktálószoftvert és a valós idejű fordítóeszközöket. A folyamat magában foglalja egy átfogó adatkészlet felhasználását, amely a beszélt nyelv hangfelvételeiből áll, párosítva a megfelelő átiratokkal.

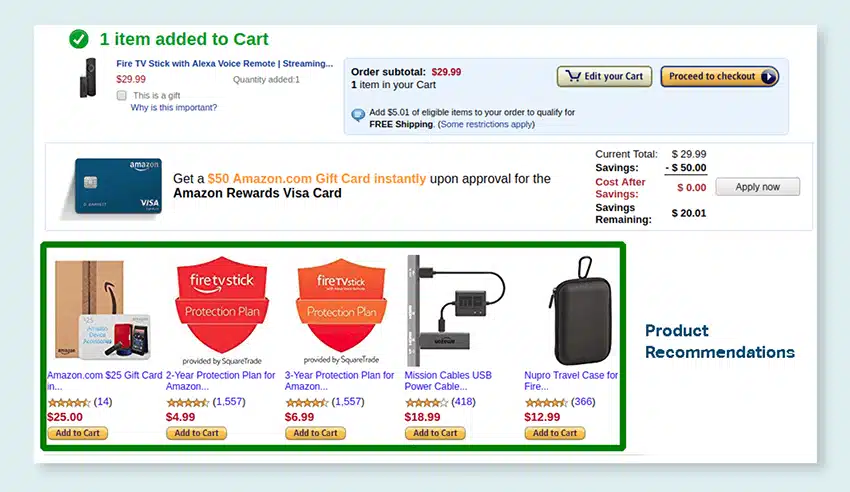

Termékjavaslatok

A vásárlók vásárlási előzményeinek kiterjedt adatkészleteinek felhasználásával dolgozzon ki modelleket, beleértve azokat a címkéket is, amelyek rámutatnak arra, hogy a vásárlók milyen termékeket szeretnének megvásárolni. A cél az, hogy precíz javaslatokat adjunk az ügyfeleknek, ezáltal növeljük az értékesítést és növeljük a vevői elégedettséget.

Képfelirat

Forradalmasítsa képértelmezési folyamatát a legmodernebb, mesterséges intelligencia által vezérelt képfeliratozási szolgáltatásunkkal. Vitalitást öntünk a képekbe azáltal, hogy pontos és kontextuálisan értelmes leírásokat készítünk. Ez megnyitja az utat az innovatív elköteleződés és interakciós lehetőségek előtt a vizuális tartalommal a közönség számára.

Szövegfelolvasó szolgáltatások képzése

Az emberi beszéd hangfelvételeiből álló kiterjedt adatkészletet kínálunk, amely ideális az AI-modellek betanításához. Ezek a modellek képesek természetes és vonzó hangokat generálni az alkalmazásokhoz, így egyedi és magával ragadó hangélményt biztosítanak a felhasználók számára.

Változatos adatkatalógusunk számos generatív mesterséges intelligencia felhasználási esetet szolgál ki

Polc nélküli orvosi adatok katalógusa és engedélyezése:

- 5M + 31 különlegességgel rögzíti és orvos audio fájljait

- 2 millió + orvosi kép a radiológiában és más szakterületeken (MRI, CT, USG, XR)

- Több mint 30 XNUMX klinikai szövegdokumentum hozzáadott értékű entitásokkal és kapcsolati kommentárokkal

Polcon kívüli beszédadatok katalógusa és licencelése:

- Több mint 40 50 óra beszédadat (100+ nyelv/XNUMX+ dialektus)

- 55+ témát érint

- Mintavételi frekvencia - 8/16/44/48 kHz

- Hang típusa - Spontán, forgatókönyv, monológ, ébresztő szavak

- Teljesen átírt hangadatkészletek több nyelven ember-ember beszélgetéshez, ember-bot, ember-ügynök call center beszélgetéshez, monológokhoz, beszédekhez, podcastokhoz stb.

Kép- és videóadat-katalógus és licencelés:

- Élelmiszer/dokumentum képgyűjtemény

- Otthonbiztonsági videógyűjtemény

- Arckép/Videó gyűjtemény

- Számlák, PO, Nyugták Dokumentumgyűjtés az OCR-hez

- Képgyűjtemény a jármű sérüléseinek észleléséhez

- Jármű rendszámtábla képgyűjtemény

- Autóbelső képgyűjtemény

- Képgyűjtemény autós sofőrrel a fókuszban

- Divattal kapcsolatos képgyűjtemény

Beszéljünk

Gyakran feltett kérdések (GYIK)

A DL az ML egy részterülete, amely több rétegű mesterséges neurális hálózatokat használ az adatok összetett mintáinak megtanulására. Az ML az AI egy részhalmaza, amely olyan algoritmusokra és modellekre összpontosít, amelyek lehetővé teszik a gépek számára, hogy tanuljanak az adatokból. A nagy nyelvi modellek (LLM-ek) a mély tanulás egy részhalmazát képezik, és közös alapot képeznek a generatív MI-vel, mivel mindkettő a mély tanulás tágabb területének összetevője.

A nagy nyelvi modellek vagy LLM-ek kiterjedt és sokoldalú nyelvi modellek, amelyeket kezdetben kiterjedt szöveges adatokra képeznek ki, hogy megragadják a nyelv alapvető aspektusait. Ezután finomhangolásra kerülnek az adott alkalmazásokhoz vagy feladatokhoz, lehetővé téve számukra, hogy bizonyos célokra adaptálják és optimalizálják őket.

Először is, a nagy nyelvi modellek a hatalmas mennyiségű adattal és több milliárd paraméterrel rendelkező kiterjedt képzésüknek köszönhetően a feladatok széles körének kezelésére képesek.

Másodszor, ezek a modellek alkalmazkodóképességet mutatnak, mivel minimális specifikus terepi képzési adatokkal finomhangolhatók.

Végül pedig az LLM-ek teljesítménye folyamatos javulást mutat, ha további adatokat és paramétereket is beépítenek, ami idővel fokozza hatékonyságukat.

A prompt tervezés magában foglalja az adott feladathoz szabott prompt létrehozását, például a kívánt kimeneti nyelv megadását egy fordítási feladatban. Az azonnali tervezés ezzel szemben a teljesítmény optimalizálására összpontosít a tartományi ismeretek beépítésével, kimeneti példák biztosításával vagy hatékony kulcsszavak használatával. Az azonnali tervezés általános fogalom, míg az azonnali tervezés egy speciális megközelítés. Míg az azonnali tervezés minden rendszernél elengedhetetlen, az azonnali tervezés kulcsfontosságúvá válik a nagy pontosságot vagy teljesítményt igénylő rendszerek esetében.

Háromféle nagy nyelvi modell létezik. Mindegyik típus más megközelítést igényel a népszerűsítéshez.

- Az általános nyelvi modellek megjósolják a következő szót a képzési adatokban szereplő nyelv alapján.

- Az utasításokkal hangolt modelleket arra tanítják, hogy előre jelezzék a bemenetben adott utasításokra adott választ.

- A párbeszédre hangolt modelleket a következő válasz generálásával tanítják meg párbeszédszerű beszélgetésre.